Changing Territories and Cross-disciplinary Multi-Scale Analyses

This project falls within the field of digital humanities, in a context of methodological renewal driven by the democratisation of hardware and software devices dedicated to the digitisation of reality and data processing. It is interested in the study of territories at different scales and their transformations, focusing on the built heritage of which they are composed. In such a diachronic and multiscalar context, it seems necessary to study the scientific approaches undertaken within systems of multidisciplinary players to produce knowledge around the same object of study.

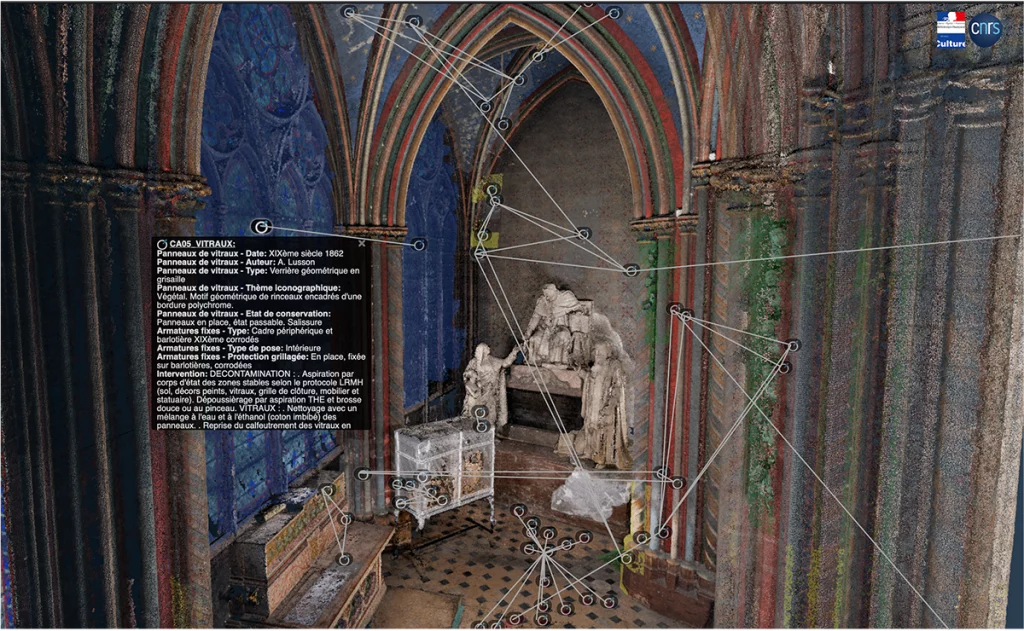

Based on the semantic enrichment of spatialised representations, the aim is to invent the mechanisms that will enable heterogeneous bodies of data to be better structured and linked in an nD context (note1), and then to study the methods of exploration, interrogation and correlation that will enable all aspects to be explored in order to produce new, perhaps unexpected, information. The approach envisaged is intended to be agile, and will involve the creation of tools that will act as intermediary objects, making it easier to aggregate the data and put it into perspective.

Note 1: by extension of 2D and 3D, the term nD refers to the n-Dimensional (multidimensional) nature of the data in a corpus. In the case of this project, the data can evolve in space (3D), as a function of time (3D+T = 4D), but can also refer to thematic dimensions. These cover information relevant to the user, characterising the nature, properties (state) and functions of the entity (object present in a building or more generally in the area).

Contact : Violette Abergel, Anaïs Guillem

Project members :

INSHS : Violette Abergel, Anaïs Guillem, Adeline Manuel, Anthony Pamart, Livio De Luca (MAP)

INS2I : Johanna Delannoy, John Samuel, Eric Boix, Gilles Gesquière (LIRIS)

Financement : MITI’s Programme Interne Blanc (PIB) 2022-2024 / MITI’s PRIME program 2024 (Projets de Recherche Interdisciplinaires Multi-Equipes)

References :

[1] D. M. Berry et A. Fagerjord, Éd., Digital humanities: knowledge and critique in a digital age. Cambridge, England: Malden, MA : Polity, 2017.

[2] L. Bountouri, M. Gergatsoulis, et C. Papatheodorou, « Integrating cultural heritage information sources », in ERCIM-DIS (Data and Information Spaces) Workshop, 2009.

[3] D. Lo Buglio, « Caractérisation de formes architecturales, Une approche expérimentale intégrant complexité et intelligibilité des représentations numériques », Université Libre de Bruxelles, Bruxelles, Belgique, 2016.

[4] A. Guillem et N. Lercari, « Global Heritage, Knowledge Provenance, and Digital Preservation: A Critical Approach », in Preserving Cultural Heritage in the Digital Age – Sending Out an S.O.S., Equinox Publishing.United Kingdom, 2021.

[5] V. Abergel, « De la numérisation des objets à la modélisation des connaissances », in Un monde commun. Comprendre le monde pour mieux l’habiter ensemble : les savoirs des humanités et des sciences humaines et sociales., CNRS Editions, 2022.

[6] L. De Luca et V. Abergel, « Vers des biens communs numériques pour construire des cathédrales de données et de connaissances pluridisciplinaires sur le patrimoine européen », Culture et Recherche, vol. La recherche culturelle, « bien commun », no 142, p. 104‑106, printemps-ét 2022.

[7] K. Chaturvedi, C. S. Smyth, G. Gesquière, T. Kutzner, et T. H. Kolbe, « Managing Versions and History Within Semantic 3D City Models for the Next Generation of CityGML », in Advances in 3D Geoinformation, A. Abdul-Rahman, Éd., in Lecture Notes in Geoinformation and Cartography. Cham: Springer International Publishing, 2017, p. 191‑206. doi: 10.1007/978-3-319-25691-7_11.

[8] J. Samuel, S. Servigne, et G. Gesquière, « Representation of concurrent points of view of urban changes for city models », J Geogr Syst, vol. 22, no 3, p. 335‑359, juill. 2020, doi: 10.1007/s10109-020-00319-1.

[9] D. Vinasco-Alvarez, J. Samuel, S. Servigne, et G. Gesquière, « Towards limiting semantic data loss in 4d urban data semantic graph generation », ISPRS Ann. Photogramm. Remote Sens. Spatial Inf. Sci., vol. VIII-4/W2-2021, p. 37‑44, oct. 2021, doi: 10.5194/isprs-annals-VIII-4-W2-2021-37-2021.

[10] D. Vinasco-Alvarez, J. S. Samuel, S. Servigne, et G. Gesquière, « Towards a semantic web representation from a 3D geospatial urban data model », in SAGEO 2021, 16ème Conférence Internationale de la Géomatique, de l’Analyse Spatiale et des Sciences de l’Information Géographique., in Actes de la Conférence SAGEO 2021. La Rochelle [Online Event], France, mai 2021, p. 227‑238. [En ligne]. Disponible sur: https://hal.science/hal-03240567

[11] C. Colin et al., « UD-SV : Plateforme d’exploration de données urbaines à n-dimensions — Espace, Temps, Thématiques », mappemonde, no 135, mars 2023, doi: 10.4000/mappemonde.8265.

[12] J. Samuel, C. Périnaud, S. Servigne, G. Gay, et G. Gesquière, « Representation and Visualization of Urban Fabric through Historical Documents », Eurographics Workshop on Graphics and Cultural Heritage, p. 10 pages, 2016, doi: 10.2312/GCH.20161399.

[13] C. Colin, J. S. Samuel, S. Servigne, Y. Miloudi, et G. Gesquière, « Visualisation d’équipements de la maintenance à l’aide de données geospatiales », in Les journées Françaises de l’Informatique Graphique (JFIG) 2021, Sophia-antipolis, France, nov. 2021. [En ligne]. Disponible sur: https://hal.science/hal-03464886

[14] A. Pamart et al., « A complete framework operating spatially-oriented RTI in a 3D/2D cultural heritage documentation and analysis tool », Int. Arch. Photogramm. Remote Sens. Spatial Inf. Sci., vol. XLII-2/W9, p. 573‑580, janv. 2019, doi: 10.5194/isprs-archives-XLII-2-W9-573-2019.

[15] A. Pamart, V. Abergel, L. de Luca, et P. Veron, « Toward a Data Fusion Index for the Assessment and Enhancement of 3D Multimodal Reconstruction of Built Cultural Heritage », Remote Sensing, vol. 15, no 9, 2023, doi: 10.3390/rs15092408.

[16] T. Messaoudi, P. Véron, G. Halin, et L. De Luca, « An ontological model for the reality-based 3D annotation of heritage building conservation state », Journal of Cultural Heritage, vol. 29, p. 100‑112, janv. 2018, doi: 10.1016/j.culher.2017.05.017.

[17] R. Roussel et L. De Luca, « An approach to build a complete digital report of the notre dame cathedral after the fire, using the aioli platform », Int. Arch. Photogramm. Remote Sens. Spatial Inf. Sci., vol. XLVIII-M-2‑2023, p. 1359‑1365, juin 2023, doi: 10.5194/isprs-archives-XLVIII-M-2-2023-1359-2023.

[18] V. Abergel, A. Manuel, A. Pamart, I. Cao, et L. De Luca, « Aïoli: A reality-based 3D annotation cloud platform for the collaborative documentation of cultural heritage artefacts », Digital Applications in Archaeology and Cultural Heritage, vol. 30, p. e00285, sept. 2023, doi: 10.1016/j.daach.2023.e00285.

[19] L. De Luca et al., « L’écosystème numérique n-dame pour l’analyse et la mémorisation multi-dimensionnelle du chantier scientifique Notre-Dame-de-Paris ». ENSA and Équipe Aria (UMR MAP) and Association de Recherche sur la Conception Architecturale Numérique, octobre 2022. [En ligne]. Disponible sur: https://hal.science/hal-03826931

[20] F. Windhager et al., « Visualization of Cultural Heritage Collection Data: State of the Art and Future Challenges », IEEE Trans. Visual. Comput. Graphics, vol. 25, no 6, p. 2311‑2330, juin 2019, doi: 10.1109/TVCG.2018.2830759.

[21] Le Robert, « sérendipité – Définitions, synonymes, conjugaison, exemples | Dictionnaire Le Robert », 2023. https://dictionnaire.lerobert.com/definition/serendipite (consulté le 25 août 2023).

[22] T. Boyer-Kassem, Éd., Scientific collaboration and collective knowledge: New Essays. New York: Oxford University Press, 2017.

[23] V. Jaillot. 3D, temporal and documented cities : formalization, visualization and navigation. PhDThesis, Université de Lyon, 2020

[24] A. Guillem. et al. (2023) ‘RCC8 for CIDOC CRM: semantic modeling of mereological and topological spatial relations in Notre-Dame de Paris’, in. Semantic Web and Ontology Design for Cultural Heritage 2023 (SWODCH) Workshop, 22nd International Semantic Web Conference (ISWC2023), Athens, Greece.